Les membres de l’Afas publient régulièrement des articles. Ils sont à retrouver ici :

Jeanne Brugère-Picoux

Professeur honoraire de pathologie médicale du bétail et des animaux de basse-cour (Ecole nationale vétérinaire d’Alfort), membre de l’Académie nationale de médecine, ancienne présidente de l’Académie vétérinaire de France

Le 20 septembre dernier, l’Académie nationale de médecine a dédié une séance à la maladie de Lyme, infection due à un spirochète du genre Borrelia dont il existe plusieurs espèces regroupées sous le complexe Borrelia burgdorferi sensu lato. Ce germe, transmis par la morsure de tiques du genre Ixodes (I. ricinus en Europe de l’Ouest), n’a été décrit qu’en 1982 par Willy Burgdorfer. Les différents aspects cliniques de cette maladie très protéiforme touchant plusieurs organes (peau, système nerveux, articulations, cœur) peuvent expliquer les difficultés de son diagnostic comme autrefois c’était le cas pour la syphilis. De plus, les tests de diagnostic ne sont pas toujours satisfaisants pour confirmer une suspicion clinique. Une mise au point scientifique s’avérait nécessaire dans ce contexte polémique sur la maladie de Lyme et les co-infections pouvant être transmises par les tiques.

Patrick Choutet (Institut national de médecine agricole) rappela très bien ce contexte où la maladie de Lyme peut être simple à reconnaître mais parfois beaucoup plus complexe.

François Bricaire (Académie nationale de médecine) considère que l’on peut avoir une « vision classique, orthodoxe de la maladie de Lyme face à une vision plus large mais incertaine ».

Ainsi, le premier conférencier, Daniel Christmann (Service des maladies infectieuses et tropicales, hôpitaux universitaires de Strasbourg) rappela comment poser un diagnostic de maladie de Lyme, caractérisée par trois phases cliniques. La première phase correspond à l’atteinte initiale qui fait suite à la contamination par la piqûre (ou morsure) d’une tique infectée. La lésion cutanée, pathognomonique, est l’érythème chronique migrant (ECM) mais elle peut passer inaperçue. La sérologie est à ce stade souvent négative, situation qui pourrait être à l’origine d’un retard à la prise en charge thérapeutique. En l’absence d’un traitement, les germes présents dans la peau peuvent se disséminer, provoquant une bactériémie (dans 25 à 50% des cas), caractérisée par une hyperthermie discrète, des céphalées et/ou des arthralgies. La phase secondaire va se traduire par des manifestations cliniques variées où prédominent les atteintes neurologiques (70 à 80%) et articulaires (50%) en Europe, un à deux mois après la contamination initiale. Les atteintes neurologiques sont variées : méningo-encéphalite (troubles de la mémoire, modification du comportement, dépression, accident ischémique cérébral, etc.), atteinte des nerfs périphériques ou des nerfs crâniens (paralysie du nerf facial notamment). Les arthrites sont moins connues en Europe qu’aux Etats-Unis (sous-estimation ?). Une atteinte cardiaque est possible dans 10% des cas, de même qu’une atteinte musculaire (crampes, myalgies, faiblesse musculaire). Parfois, et plutôt chez l’enfant, on observe un lymphocytome cutané bénin borrélien, le plus souvent localisé au lobule de l’oreille.

La maladie de Lyme reconnaît aussi une phase tertiaire se manifestant 3 à 5 ans après la contamination. Cette phase tertiaire correspond en fait à une évolution chronique où prédominent les atteintes neurologiques et articulaires. L’atteinte de l’encéphale est plus polymorphe, rappelant les tableaux neurologiques plus classiques de sclérose en plaques ou de sclérose latérale amyotrophique. La piqûre de tique n’étant observée que dans la moitié des cas, il est parfois bien difficile de reconnaître une maladie de Lyme, en particulier quand il ne s’agit pas d’une forme classique.

Le Pr Benoît Jaulhac (CNR des Borrelia-Borreliella et EA 7290, faculté de médecine et hôpitaux universitaires de Strasbourg) a présenté les difficultés du diagnostic de la maladie de Lyme, où les tests biologiques, principalement basés sur la sérologie, sont essentiels, à l’exception de l’érythème migrant dont le diagnostic reste clinique. Il a rappelé qu’une enquête épidémiologique menée en Alsace en 2010 avait révélé un taux d’incidence relativement élevé, oscillant entre 160 et 200 cas pour 100 000 habitants (alors qu’au niveau national, l’incidence indiquée en 2009 par le réseau sentinelle est de 40 à 50 cas pour 100 000 habitants, l’Est et le Centre de la France étant les plus touchés).

La présentation de Christian Perronne (infectiologie, hôpital de Garches), consacrée à la sémiologie persistante polymorphe après une piqûre de tique permettant de suspecter la maladie de Lyme a retenu l’attention du public. Tout n’est pas Lyme mais il faut reconnaître qu’il peut y avoir des formes persistantes pouvant être qualifiées de « formes chroniques » (correspondant vraisemblablement aux « formes tertiaires » des conférenciers précédents). Il ne faut pas oublier que les tiques peuvent être aussi porteuses d’autres agents pathogènes et la possibilité de co-infections, pour lesquelles il n’y a pas de test de diagnostic disponible en routine, complique le problème du diagnostic d’une maladie de Lyme. Le Pr Perronne a aussi souligné la complexité de la standardisation des tests de diagnostic et de l’interprétation des résultats positifs et/ou négatifs selon qu’il s’agit d’une PCR, d’un western blot et/ou d’un examen sérologique. Une recherche fondamentale s’avère indispensable face aux résultats contradictoires concernant le traitement anti-infectieux de la forme chronique de la maladie de Lyme. De même, des études cliniques sont nécessaires pour évaluer les meilleurs médicaments efficaces pour le traitement d’entretien en cas de symptomatologie persistante.

Enfin, Muriel Vayssier (INRA, UMR BIPAR, Anses, École nationale vétérinaire d’Alfort) a présenté les différents agents pathogènes (Borrelia spp., Anaplasma phagocytophylum, Bartonella henselae, etc.) que les tiques sont susceptibles de transmettre avec la possibilité de co-infections et « l’augmentation du risque de multiplication de ces vecteurs liée à la douceur hivernale, à l’augmentation du réservoir sauvage en zone forestière et à la diminution des prédateurs se nourrissant de leurs larves ». Elle a aussi rappelé la découverte récente d’une fièvre hémorragique de Crimée-Congo autochtone mortelle en Espagne, le Nairovirus responsable étant transmis par une tique (Hyalomma marginatum) que l’on peut retrouver aussi dans le sud de la France. Enfin, elle a souligné les difficultés de la lutte contre les maladies vectorielles en citant à juste titre le Pr Agustin Estrada-Pena : « Quand comprendrons-nous que nous ne pouvons éradiquer les tiques et les agents pathogènes qu'elles transmettent ? En revanche, nous devons informer, nous protéger et nous adapter. »

Le Pr Bricaire a conclu que la maladie de Lyme était « une maladie de pays riche, en Europe et aux États-Unis ». Ses conclusions ont été reprises dans la prise de position publiée ultérieurement par l’Académie nationale de médecine, en particulier au sujet « des controverses concernant la « Lyme chronique », ce qui correspond à une phase tardive et qu’il vaut mieux rapprocher des phases tertiaires de l’infection ». Ainsi « la maladie de Lyme pourrait être une mauvaise réponse à une question légitime de malades qui souffrent, insatisfaits par la prise en charge de leurs troubles, qui veulent être écoutés et auxquels il serait donné de faux espoirs. Il importe de progresser en proposant : la poursuite des recherches sur la responsabilité d’autres agents infectieux ; la mise au point et l’amélioration des différents tests de diagnostic ; surtout la mise en place de protocoles thérapeutiques contrôlés, s’appuyant sur des choix rationalisés de molécules, versus placebo, avec des malades volontaires sélectionnés pour constituer des groupes homogènes et comparables. Cette démarche difficile, longue, est à la fois raisonnable et éthique ».

Quelques jours plus tard (le 29 septembre), le ministère de la Santé a annoncé le lancement d’un plan national de lutte contre la maladie de Lyme et autres maladies à tiques. Ce plan propose aux malades et aux médecins concernés de participer ensemble à l’élaboration d’un protocole de diagnostic et de soins. Ce plan devrait permettre d’éviter les errances que connaissent certains malades allant jusqu’en Allemagne pour se faire confirmer un diagnostic ou, inversement, permettre un diagnostic différentiel démontrant que la piqûre de tique n’est pas obligatoirement en cause dans le syndrome observé.

Les associations de malades avaient souvent montré avec le temps que leur maladie n’était pas imaginaire et qu’il existait parfois une affection bien réelle et non diagnostiquée par certains médecins n’ayant pas eu la formation nécessaire pour reconnaître une maladie de Lyme ou une autre infection transmise par une piqûre de tique. Le plan du Gouvernement propose d’améliorer les tests de diagnostic (évaluation des kits déjà disponibles, développement de nouveaux outils de dépistage, en particulier pour les autres microbes que Borrelia). On peut d’ailleurs noter l’avance de la médecine vétérinaire sur la médecine humaine, notamment si l’on se rappelle le travail précurseur d’un vétérinaire en Bretagne, Guy Joncour qui a su convaincre ses confrères de l’intérêt de détecter une zoonose, l’ehrlichiose granulocytaire bovine (due à Anaplasma phagocytophilum), dès le début des années deux mille. Alors que la maladie humaine est vraisemblablement sous-estimée en France, elle est émergente chez l’Homme depuis les années quatre-vingt dix aux Etats-Unis.

En conclusion, il importe prévenir ces maladies émergentes (« Mieux vaut prévenir que mal diagnostiquer et mal guérir » selon notre confrère Patrick Bourdeau, de l’Ecole nationale vétérinaire de Nantes, dénommée Oniris). Il faut surtout sensibiliser les personnes à la prévention des piqûres (ou morsures) de tiques et contrôler la population de ces vecteurs (affiches, contrôles après promenades en zone dangereuse, limiter le réservoir des animaux sauvages pouvant héberger des tiques, etc.).

Il importe aussi de savoir mieux diagnostiquer ces maladies pour les combattre efficacement chez la personne infectée, qu’il s’agisse d’une infection primaire ou de formes cliniques plus complexes liées à une co-infection et/ou à une évolution chronique.

Comme l’a rappelé Muriel Vayssier, l’Agence nationale de la recherche (ANR) vient de financer un projet de recherche collaboratif entre chercheurs en santé animale, humaine et en écologie, médecins et vétérinaires. Les connaissances sur ces maladies devraient donc être renforcées dans le futur.

Jean-François Cervel

Commission nationale française pour l’Unesco, IGAENR

Quelques éléments factuels de contexte

Qu’est-ce qu’un chercheur scientifique aujourd’hui ? Quels changements depuis 1974 ? En 40 ans, des changements profonds sont intervenus.

Eléments quantitatifs

La chaîne de la R&D, Recherche-Développement-Technologie (Technology Readiness Level, TRL) a pris une importance considérable avec de nombreux acteurs sur tous ses segments, depuis la recherche la plus fondamentale jusqu’aux développements à vocation économique, acteurs ayant des profils et des statuts divers : ingénieurs, ingénieurs de recherche, chercheurs…, ce qui pose la question de la complémentarité entre ces différents profils et leur place dans les différentes institutions qui les emploient.

Evolutions quantitatives : il y a environ 8 millions de chercheurs aujourd’hui dans le monde (chiffre du dernier rapport de l'Unesco sur la science sorti en 2015. Les derniers chiffres dans ce rapport sont souvent de 2012 ou 2013). Depuis 2007, leur nombre a augmenté de 21%.

Cette croissance a pour conséquence une forte augmentation (le rapport de l’Unesco dit "une explosion") du nombre des publications scientifiques.

L’Union européenne reste leader mondial pour le nombre de chercheurs, avec 22,2%, suivie par la Chine (19,7%), qui a dépassé les Etats-Unis (16,7%), le Japon (8,5%), la Fédération de Russie (5,7%). Ces cinq premiers représentent donc près de 73% du total. Mais la population des chercheurs scientifiques s’accroît dans tous les pays et la part des cinq premiers diminue.

Avec des taux pouvant atteindre près de 8 chercheurs pour 1000 habitants dans certains pays (Finlande, Israël), 6 à 7 au Danemark, à Singapour, en Corée (6,5), 5,1 au Japon, autour de 4 dans différents pays : Allemagne (4,3), France (4,1), Royaume-Uni (4,1), Etats-Unis (4).

En pour mille de la population active : Finlande 14,8, Corée 11,5, Japon 10, Suède 9,8, Etats-Unis 9,1, France 8,8, Allemagne 7,9…

Il y a plus de scientifiques vivants qu’il n’y en a eu auparavant dans l’histoire de l’humanité. C’est l’un des éléments de caractérisation de la fameuse "société de la connaissance" dont on parle tant.

Mobilité et concurrence

La mobilité géographique, la mobilité institutionnelle, la mobilité entre le secteur public et le secteur privé se sont fortement développées au cours des quatre dernières décennies.

Avec une part croissante de chercheurs dans le secteur privé, dans les entreprises, et un croisement fort entre l’économie et la recherche, dans un mouvement complexe amont-aval/aval-amont, tous les pays ayant fait de l’innovation et donc du soutien à l’innovation un axe déterminant de leur politique. Alors que les logiques, les objectifs et les modalités d’action des chercheurs "académiques" et des chercheurs en entreprise sont différents avec, d’un côté, une logique de publication dans un contexte de compétition-collaboration (on parle quelquefois de "coopétition") entre les institutions et entre les personnes, et de l’autre, une logique de protection dans un contexte de concurrence économique (brevets, licences…).

Avec une concurrence forte sur le marché mondial des personnels scientifiques entre les établissements, les laboratoires, les entreprises, les pays. La compétition pour attirer ces travailleurs qualifiés du plus haut niveau s’accentue même si les mouvements sont différents au fil du temps, depuis les années soixante du XXe siècle. Ainsi le phénomène du brain drain, qui a entraîné notamment le fameux facteur CI (chinois-indiens) dans la Silicon Valley, a été suivi par des politiques de "retour au pays" conduites par la Chine, l’Inde ou d’autres.

Ce mouvement se poursuit si on regarde les flux de doctorants à l’international. Il est à noter que plus de la moitié sont en science et science de l’ingénieur. Dans ces disciplines, la moitié sont aux Etats-Unis, 10% au Royaume-Uni et 7% en France, les trois premiers pays d’accueil (voir rapport Unesco, chapitre Innovation).

Très grosse compétition pour trouver des places dans les entreprises américaines (cf. loterie pour obtenir les visas). Mais on constate aussi une augmentation des flux de retour vers les pays d’origine, qui développent souvent des politiques d’attractivité pour inciter leurs nationaux à revenir.

Institutions et statuts

Avec une affirmation de plus en plus forte des universités comme acteurs globaux à l’échelle mondiale (voir article de Patrick Aebischer, président de l’EPFL : "Universities: increasingly global players" : l’université de demain sera une entreprise globale à multi-niveaux, avec un site central et plusieurs antennes à travers le monde mises en œuvre avec des partenaires stratégiques ; elle aura une forte présence en ligne).

Avec, évidemment, un débat sur les statuts de ces personnels, avec les logiques opposées du contrat qui est le modèle anglo-saxon et les statuts de fonctionnaires de l’Etat tels qu’on peut les connaître en France. Le modèle contractuel se développe largement, avec une logique de concurrence et de politiques d’attractivité (qualité des équipes, de l’environnement de travail, rémunérations...) et, notamment lorsque les circonstances budgétaires sont plus difficiles, le développement de la précarité des post-doctorants (ils ont augmenté de 150% aux Etats-Unis entre 2000 et 2012).

Quelques éléments pour la France

Les chiffres pour la France sont, en 2012, de 260 000 chercheurs (en ETP), dont environ 157 000 en entreprises (dont environ 13% titulaires d’un doctorat), et près de 103 000 dans le secteur public : chercheurs des EPST et des EPIC, enseignants-chercheurs, ingénieurs de recherche (5%), doctorants rémunérés (12%). Pour un total de personnels employés dans la R&D de 412 000 (38% de personnels de soutien). En 20 ans, entre 1992 et 2012, le personnel total employé dans la R&D est passé de 291 000 à 412 000 (+40%), le personnel chercheur de 139 000 à 260 000 (+86%) en ETP.

Pour ce qui concerne le secteur public, en dépit de l’apparente unité donnée par le statut de fonctionnaire ou d’agent public de l’Etat, forte spécificité, mais aussi diversité et complexité. Il y avait en 2012-2013 plus de 20 000 professeurs et plus de 36 000 maîtres de conférences, toutes disciplines confondues, dans la catégorie des enseignants-chercheurs, environ 17 000 chercheurs (DR et CR) en EPST (CNRS, Inra, Inserm, IRD, Inria, Ined…) et l’équivalent dans les EPIC (CEA, Cnes, BRGM, Ifremer….). Forte particularité des statuts, notamment celui totalement spécifique des enseignants-chercheurs des établissements d’enseignement supérieurs.

Il faut donc tenir compte de ces changements profonds et encore en cours de développement pour réfléchir sur la modification de la recommandation de l’Unesco sur la condition du chercheur scientifique.

Alain Foucault

Professeur émérite du Muséum national d'histoire naturelle (Paris)

On sait que les grands glaciers, au Groenland et en Antarctique, ont conservé la mémoire de l’évolution de notre climat, et cela depuis au moins 800 000 ans et sans doute davantage. De grands carottages dans leurs glaces ont pu le mettre en évidence.

Les petits glaciers de montagne ont une moins longue mémoire, au plus quelques siècles, mais les renseignements qu’ils peuvent donner sont précieux, étant répartis dans des régions autres que les domaines polaires. Mais ils sont en danger car le réchauffement climatique actuel les fait fondre. Si l’on veut conserver leurs enregistrements et pouvoir les étudier dans l’avenir par des méthodes encore inconnues, il est urgent de prélever et conserver ces archives.

C’est pourquoi un programme international a été mis en œuvre pour sauvegarder la mémoire des glaciers de montagne. Le glacier du col du Dôme (4300 m, massif du mont Blanc) a été choisi pour commencer ces prélèvements. Cette première campagne de carottage a commencé le 15 août 2016 et s’est achevée le 29 août. Trois carottes ont été prélevées (de 126 m, 128 m et 129 m) permettant de remonter à 150 ans. Elles ont été transportées à Grenoble au Laboratoire de glaciologie et géophysique de l’environnement (LGGE), université Grenoble Alpes, CNRS. L’une d’entre elles sera analysée en 2019 pour constituer une base de données disponible pour l’ensemble de la communauté scientifique mondiale. Les deux autres seront acheminées par bateau puis par véhicules à chenilles sur les hauts plateaux de l’Antarctique, en 2020, pour être stockées à la base Concordia, gérée par l’Institut polaire français Paul-Emile Victor (IPEV) et son partenaire italien, le Programme national de recherche antarctique (PNRA). A terme, ce sont des dizaines de carottes de glace patrimoine qui devraient être stockées dans une cave creusée sous la neige, par -54°C, le congélateur le plus sûr - et naturel - du monde.

Une deuxième mission, plus longue et plus complexe, se déroulera en 2017 dans les Andes en Bolivie (glacier Illimani). D’autres pays sont déjà candidats pour s’inscrire dans ce projet et sauvegarder la mémoire des glaciers auxquels ils ont accès : l’Allemagne, l’Autriche, la Suisse, le Brésil, les États-Unis, la Russie, la Chine, le Népal, le Canada.

Pour aller plus loin :

http://www.osug.fr/sciences-pour-tous/le-coin-des-medias/communiques-de-presse/sauvegarder-la-memoire-de-la-glace.html

https://www.facebook.com/ProtectingIceMemory/

http://www2.cnrs.fr/presse/communique/4631.htm?theme1=6

http://fondation.univ-grenoble-alpes.fr/ice-memory

Alain Foucault

Professeur émérite du Muséum national d'histoire naturelle (Paris)

Balazuc (44° 30′ 24,4″ Nord, 4° 22′ 22″ Est) est un beau village construit sur une rive escarpée de l’Ardèche à 20 km à vol d’oiseau de la maintenant célèbre grotte Chauvet du Pont d’Arc. C’est un plaisir de flâner dans ses ruelles et d’y découvrir d’impressionnantes vues sur la rivière.

Mais Balazuc possède désormais une raison de plus d’être visité. Depuis avril 2016 s’y est ouvert un musée de géologie. Il n’est pas grand, mais les restes paléontologiques qu’il montre sont particuliers et méritent assurément d’être vus. La plupart, en effet, proviennent des couches de diatomites d’une colline connue comme la montagne d’Andance, qui s’élève à quelques kilomètres au sud-est de Privas.

Les diatomites sont des dépôts lacustres constitués par l’accumulation d’innombrables enveloppes siliceuses d’algues vertes unicellulaires microscopiques : les diatomées. Ces enveloppes sont d’une grande finesse et montrent une dentelle de dessins ajourés.

Bien des lacs actuels sont habités par des diatomées. Comme leur croissance est liée à l’alternance des saisons et que la sédimentation du lac lui-même est conditionnée par cette alternance, il s’ensuit que les sédiments qui en résultent présentent une alternance de très fins lits annuels. C’est ainsi une sorte de livre où chaque page marque une année.

Cette sédimentation peut s’étaler sur des millénaires et donner naissance à des formations de diatomite, roche très blanche (la matière organique s’étant oxydée au cours du temps), très légère et montrant de fins lits qui, comme on l’a dit, correspondent chacun à une année de dépôt.

Si la structure de ces lits s’est aussi bien conservée, c’est que le sédiment n’a pas été soumis à ce qu’il souffre habituellement : la bioturbation, c’est-à-dire le labourage par les organismes qui vivent habituellement sur le fond. Cela est dû à la rareté de l’oxygène, habituelle au fond de ces lacs.

Une conséquence est que les organismes animaux ou végétaux qui ont pu tomber sur ce fond sont parfaitement conservés. Et c’est justement ce qui fait un des principaux intérêts du musée de Balazuc.

C’est ainsi que l’on y verra une impressionnante collection de feuilles d’arbres qui donnent un aperçu de la flore entourant alors (c’est-à-dire il y a 7 ou 8 millions d’années) le lac fossile. On verra aussi de nombreux exemplaires de fossiles d’insectes, d’invertébrés (dont des grenouilles), de vertébrés, notamment des poissons, mais aussi de mammifères, dont un ancêtre du cheval, Hipparion.

Mais bien d’autres fossiles attendent le visiteur de ce très beau petit musée dont l’ouverture et les collections doivent beaucoup à la ténacité d’un passionné de paléontologie, Bernard Riou.

Nicole Guiso

Institut Pasteur, ex-responsable de l’Unité de recherche "Prévention et thérapies moléculaires des maladies humaines" et ex-directrice des Centres nationaux de référence de la coqueluche et autres bordetelloses et des corynebactéries du complexe diphtheriae

La diphtérie et la coqueluche sont deux maladies respiratoires très sévères qui peuvent atteindre l’homme quel que soit son âge. Elles sont parmi les plus anciennes maladies à prévention vaccinale. Après plusieurs décennies d’utilisation des vaccins diphtérique et coquelucheux, quelles sont les conséquences de leur utilisation ?

L’incidence de la diphtérie et de la coqueluche a considérablement diminué depuis l‘introduction de la vaccination. Cependant, si la diphtérie est bien contrôlée, la coqueluche ne l’est toujours pas. De plus, la transmission de ces maladies, leurs agents et les classes d’âge touchées ont évolué depuis l’introduction de la vaccination et une poursuite de la surveillance de ces maladies, que l’on pensait oubliées, doit être poursuivie afin d’adapter régulièrement les stratégies vaccinales.

La vaccination diphtérique

La diphtérie est une maladie très ancienne, déjà connue sous Hippocrate. Elle se présente sous deux formes, respiratoire ou cutanée. La transmission se fait par aérosols ou par le toucher. Les deux types de maladies ont pour agent des bactéries : Corynebacterium diphtheriae et beaucoup plus rarement C. ulcerans, toutes les deux capables de produire la toxine diphtérique quand elles sont infectées elles-mêmes par un phage. Cette toxine a été rapidement identifié et purifiée et un vaccin dit acellulaire a été développé, composé de toxine diphtérique inactivée chimiquement.

Avant l’introduction de la vaccination, la maladie était observée dans le monde entier, cycliquement tous les 10-12 ans. Il était rare que les enfants de moins de six mois soient infectés, suggérant que l’immunité maternelle était importante pour leur protection. Cette maladie était rare chez les adultes en raison de leur immunité due aux rappels naturels réguliers par contact avec des personnes infectées. Après l’introduction de la vaccination dans les années quarante, l’incidence de la diphtérie a considérablement diminué et dans les années quatre-vingt est devenue exceptionnelle dans la plupart des pays industrialisés. Cependant, une importante épidémie eut lieu dans les années quatre-vingt dix dans les pays de l’ex-URSS avec 150 000 cas et 5000 décès, principalement chez les adultes. Cette épidémie était essentiellement due à une baisse de l’immunité de la population en raison d’une diminution de la couverture vaccinale et de la disparition des rappels naturels. Cet épisode a ainsi montré qu’une couverture vaccinale élevée était indispensable pour contrôler la maladie chez l’enfant mais aussi chez les adolescents et les adultes.

Grâce à la surveillance de la maladie, ces dernières années deux autres observations ont été faites dans les pays à haute couverture vaccinale : (i) il n’y a plus de cas autochtones dus à C. diphteriae mais on observe des cas importés par des patients non à jour de leur vaccination ; (ii) des infections dues à des C. ulcerans produisant la toxine. Des infections sévères, certaines mortelles, ont été observées en Europe et en Amérique du Nord chez des personnes âgées, insuffisamment immunes, en contact avec des animaux de compagnie comme les chats et les chiens. Ceci indique que les personnes âgées sont insuffisamment vaccinées malgré les recommandations vaccinales.

La vaccination coquelucheuse

La coqueluche est une maladie respiratoire aussi contagieuse que la rougeole et est particulièrement dramatique pour les nourrissons et les personnes à risque, telles les femmes enceintes ou les personnes âgées. C’est une maladie récente, apparue il y a environ 500 ans. Les symptômes cliniques de la coqueluche durent en général 6 à 12 semaines, quelquefois plus longtemps. Ils comportent trois périodes : (i) une période dite catarrhale peu différente d’une infection respiratoire virale et très atypique de 7 à 14 jours, pendant laquelle la personne est très contagieuse ; (ii) la période paroxystique qui dure entre 6 à 8 semaines, sans fièvre, où la toux est le symptôme principal, apparaissant par quintes. La reprise inspiratoire est souvent difficile et suive d’apnée, bradychardie, cyanose, vomissements, côte cassée ; (iii) la phase de convalescence se fait lentement avec une diminution progressive des quintes de toux. Cette maladie est cyclique, encore actuellement, tous les 3 à 5 ans. Les agents de la maladie sont Bordetella pertussis et plus rarement B. parapertussis. Ce sont des bactéries difficiles à isoler et cultiver.

Avant l’introduction de la vaccination, la maladie était considérée comme pédiatrique. Contrairement à C. diphtheriae, les difficultés à cultiver B. pertussis ont empêché d’isoler rapidement une toxine et le premier vaccin qui a été développé a été un vaccin coquelucheux composé de bactéries entières inactivées à la chaleur ou chimiquement (Vaccin Ce). Comme la maladie était considérée comme pédiatrique, seuls les nourrissons ont été vaccinés. Cette vaccination a permis une diminution très importante de la mortalité et de la morbidité dues à la coqueluche. Cependant les vaccins Ce (i) sont très difficiles à produire de façon reproductible et leur efficacité est variable de 35 à 94% ; (ii) induisent une durée de protection courte… tout comme la maladie naturelle. En effet, il a été observé, environ 25 ans après l’introduction de la vaccination, un changement d’une transmission de la maladie d’enfants à enfants à une transmission adolescents-adultes à nouveau-nés non vaccinés, pour qui la maladie peut être mortelle. Cette observation a montré que les adolescents ayant été vaccinés dans l’enfance ou les adultes ayant eu la maladie étant jeunes n’étaient plus immuns en raison de la disparition de rappels naturels, c’est-à-dire de contacts avec des enfants infectés. L’immunité vaccinale, tout comme l’immunité infectieuse, est donc de courte durée, indiquant la nécessité de rappels vaccinaux ; (iii) induisent des effets secondaires, réversibles, les empêchant d’être utilisés pour des rappels vaccinaux !

Après des dizaines d’années de recherche, plusieurs protéines bactériennes impliquées dans la virulence de la bactérie ont été isolées et purifiées. Des vaccins coquelucheux acellulaires constitués de 1 à 5 protéines purifiées et inactivées ont été développés (vaccins Ca pour l’enfant et ca pour l’adolescent et l’adulte car ils contiennent des quantités plus faibles de protéines bactériennes). Ces vaccins induisent moins d’effets secondaires et peuvent être utilisés pour des rappels vaccinaux. Les deux types de vaccins ont montré une efficacité certaine vis-à-vis de la maladie sévère mais induisent une immunité de courte durée (entre 5 à 8 ans), qui serait un peu plus courte après vaccination avec les vaccins Ca.

L’Amérique du Nord et l’Europe n’utilisent plus que ces vaccins Ca et ce depuis la fin des années quatre-vingt dix mais la plupart des autres régions du monde utilisent toujours des vaccins Ce.

En 2012-2013, un cycle important de coqueluche a eu lieu. Les raisons seraient multiples : (i) diagnostic moléculaire de la maladie plus sensible depuis quelques années ; (ii) diminution de la couverture vaccinale dans certaines régions ; (iii) recommandations vaccinales mal suivies ; (iv) différences entre l’immunité induite par les vaccins Ca (ciblant quelques protéines bactériennes) et Ce (ciblant la bactérie entière) ; (v) changement des espèces bactériennes aussi bien B. pertussis que B. parapertussis dans les régions utilisant des vaccins Ca. Ces changements n’impactent pas la virulence de la bactérie, ni sa transmission malheureusement, mais pourraient diminuer légèrement la protection induite par les vaccins. L’ensemble de ces raisons font que la surveillance de la coqueluche doit continuer afin d’adapter les stratégies vaccinales régulièrement.

Conclusions

Les vaccins diphtérique et coquelucheux ont permis une diminution très importante de la mortalité due à la diphtérie et la coqueluche. Cependant, leur surveillance par les autorités de santé publiques nécessite une estimation régulière (i) de la couverture vaccinale de la population ; (ii) de la durée de l’immunité induite par la vaccination ; (iii) de l’évolution de la population bactérienne ciblée par le vaccin en fonction de l’immunité de la population ; (iv) l’évaluation régulière de la stratégie vaccinale choisie en fonction de l’épidémiologie de la maladie. Cette évaluation doit se faire en utilisant des définitions de cas précises et des diagnostics biologiques spécifiques et sensibles, qui sont modifiés en fonction de l’évolution de la technologie. Il est important de prendre en compte aussi les changements au niveau de la population, tel l’augmentation de l’âge de la vie ; au niveau des modes de vie, tels l’alimentation et les déplacements ; au niveau de la transmission de la maladie au sein des populations…

La surveillance des maladies à prévention vaccinale doit donc être poursuivie, même lorsqu’une maladie semble contrôlée, afin d’adapter régulièrement les stratégies vaccinales. Il est important de se rappeler que les vaccins ne sont pas que pour les enfants.

Jean-François Cervel

Commission nationale française pour l’Unesco, IGAENR

Le feuilleton de la réforme de l’Ecole polytechnique et, à travers le cas de cette école prestigieuse, de l’évolution du dispositif français des écoles d’ingénieurs, vient de connaître un nouvel épisode avec les déclarations de M. Bernard Attali dans le journal Les Echos (21/05/2016) et le rapport de M. le sénateur Berson sur le projet Paris-Saclay. Quand s’arrêtera-t-il ? Comme toutes les grandes séries, il a sans doute encore de beaux jours devant lui ! Les péripéties qui ont marqué les dernières décennies témoignent en ce sens…

Sans prétendre en aucune manière à l’exhaustivité, on peut rappeler quelques épisodes passés en ne remontant qu’aux années quatre-vingt dix du siècle dernier.

En 1988, M. Roger Fauroux, alors ministre de l’Industrie, avait fort justement mis l’accent dans son programme d’action à la tête de ce ministère, sur la qualité des ressources humaines pour l’industrie. Il avait lancé à ce titre quelques initiatives fortes parmi lesquelles :

- donner un statut d’établissements publics aux écoles des mines, qui jusque-là étaient gérés en régie directe par son ministère, et créer une sixième école des mines (qui sera implantée à Albi en raison de la fermeture des mines de Carmaux…) ;

- développer le réseau des centres de l’ENSAM en créant notamment un centre franco-allemand ;

- développer l’apprentissage industriel qui était alors moribond ;

- créer une université technologique de Paris en regroupant l’Ecole polytechnique et ses écoles d’application.

Cette dernière initiative tourna assez vite court en raison notamment de l’opposition du ministère de l’Education nationale qui s’évertua, dans les années qui suivirent, à créer de nouvelles formations qui avaient pour objectif de concurrencer les diplômes d’ingénieurs (magistères, projets de diplômes à Bac +6…).

L’idée fut néanmoins reprise dans les années suivantes, avec le projet Paris-Tech qui avait pour ambition de regrouper une dizaine d’écoles d’ingénieurs parmi les plus importantes afin notamment d’affirmer leur visibilité internationale. Malgré des avancées significatives avec la création d’un pôle de recherche et d’enseignement supérieur à statut d’EPCS (établissement public de coopération scientifique), ce grand projet se heurta à de multiples difficultés et oppositions, tant internes qu’externes, qui ont finalement abouti à sa disparition. L’absence de volonté interministérielle est l’une des raisons, parmi de nombreuses autres, de cet échec extrêmement dommageable pour l’efficacité du dispositif français d’enseignement supérieur, de recherche et d’innovation.

S’ensuivirent des initiatives diverses portées par différents ministères et notamment la réforme des statuts de l’Ecole polytechnique, la création de l’Institut Mines-Télécom, les regroupements d’établissements dans le cadre des initiatives d’excellence, la mise en place des COMUE (communautés d’universités et établissements) créées par la loi de 2013, etc.

Ces réalisations désordonnées sont le fruit des activités des différentes institutions en présence et de leurs ministères de tutelle respectifs et de l’absence de choix entre trois logiques différentes quant à la politique à conduire en matière de réorganisation du paysage de l’enseignement supérieur et de recherche français.

Une première logique est de type territoriale. Il s’agit de constituer des regroupements d’établissements qui s’inscrivent dans un même périmètre géographique pour constituer de grandes universités pluridisciplinaires susceptibles d’accroître leur visibilité internationale.

Une deuxième logique est de verticalité sectorielle. Il s’agit de regrouper des établissements relevant d’un même secteur scientifico-économique sous la houlette de grands ministères dits «techniques». L’Institut agronomique, vétérinaire et forestier pour le ministère de l’Agriculture, ou l’Institut Mines-Télécom pour le ministère de l’Economie en sont de bons exemples.

Une troisième logique est de regrouper les établissements par catégories et en particulier de créer, d’une part, des universités de recherche et, d’autre part, des universités de technologie par regroupements des principales écoles d’ingénieurs.

Cette troisième logique me paraît être celle qui est la plus porteuse d’avenir. La France est en effet l’un des seuls grands pays à ne pas disposer d’universités de technologie au sens international de ce terme en dépit de l’existence, depuis les années soixante-dix, d’établissements portant ce nom. On en trouve aux Etats-Unis d’Amérique, on en trouve dans les pays de tradition germanique, on en trouve désormais dans les pays émergents. Une telle évolution permettrait de valoriser les grandes qualités du système français de formation d’ingénieurs, dont l’efficacité est clairement plébiscitée par toutes les entreprises qui travaillent en étroite relation avec lui. Elle lui permettrait de monter en puissance et d’effectuer les regroupements indispensables pour atteindre une véritable masse critique sans tomber dans le gigantisme.

Ces regroupements pourraient prendre la forme soit de réseaux organisés sur l’ensemble du territoire national par des établissements de même profil, soit d’entités territoriales.

Ces regroupements devraient être dotés de statuts de type industriel et commercial permettant la plus large capacité d’initiative en matière de formation initiale, de formation continue, de recherche, d’innovation, de participation à l’économie et de relations avec les entreprises. Ils devraient évidemment travailler en relation étroite avec le tissu économique et notamment avec les centres techniques industriels et avec les grandes institutions de recherche technologique (CEA, ONERA, INRIA…) et pourraient travailler en complémentarité avec des écoles de management.

Pourquoi l’Ecole polytechnique fédérale de Lausanne est-elle devenue en peu d’années une université technologique de notoriété mondiale et pourquoi n’avons nous pas l’équivalent en France alors que le potentiel existant est tout à fait considérable ? Parce que nous avons perdu 25 ans, depuis le projet de Roger Fauroux, en batailles internes et en initiatives contradictoires. Il est peut-être encore temps d’y remédier.

Jeanne Brugère-Picoux

Professeur honoraire de pathologie médicale du bétail et des animaux de basse-cour (Ecole nationale vétérinaire d’Alfort), membre de l’Académie nationale de médecine, ancienne présidente de l’Académie vétérinaire de France

Le 5 avril 2016, l’Institut vétérinaire norvégien (Norwegian Veterinary Institute) d’Oslo a confirmé le diagnostic d’une maladie du dépérissement chronique (MDC) chez un renne (Rangifer tarandus tarandus)[1]. Il s’agissait d’une femelle adulte observée dans un parc dans le sud de la Norvège et ayant présenté un amaigrissement. A sa mort, son encéphale a été prélevé, conformément au plan de surveillance national de la MDC chez les cervidés âgés de plus de 18 mois. La maladie a été confirmée par des examens biochimiques et histo-chimiques. Il s’agit du premier cas déclaré de MDC en Europe.

En effet, la maladie du dépérissement chronique est une encéphalopathie spongiforme transmissible (EST) qui n’est rencontré qu’en Amérique du Nord (à l’exception d’un cas importé du Canada en Corée du Sud) chez certaines espèces de cervidés : Cerf hémione ou Cerf mulet (Odocoileus hemionus), cerf de Virginie (Odocoileus virginianus), Wapiti des montagnes Rocheuses (Cervus elaphus nelsoni) et Orignal ou Elan d’Amérique (Alces alces shirasi). Cette affection est rencontrée chez des espèces sauvages élevés en liberté ou dans des fermes d’élevage.

L’Europe s’était inquiétée dès le début des années deux mille du risque de MDC chez les cervidés européens et j’avais participé au premier rapport d’expertise sur ce sujet[2]. Dès 2004, l’EFSA (European Food Safety Authority) a mis en place un plan de surveillance européen pour cette maladie. Les résultats[3] des enquêtes réalisées entre 2006 et 2010 en Europe ont démontré la difficulté de déceler cette affection dans une population animale surtout sauvage avec seulement 13 000 prélèvements effectués, les résultats négatifs obtenus ne permettant pas d’exclure son existence sous une forme sporadique.

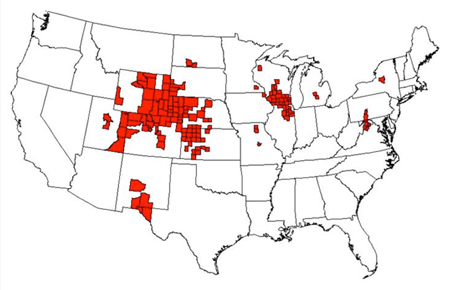

Contrairement à l’Europe, l’Amérique du Nord est particulièrement inquiète de la présence de la MDC sur son territoire du fait de son caractère endémique. Celle-ci a été décrite pour la première fois en 1967 dans le Colorado, puis identifiée en tant que maladie à prion en 1978. Au début, la MDC semblait localisée uniquement dans les Etats du Colorado et du Wyoming. La mise en place d’une surveillance nationale a permis de découvrir que la maladie était plus fréquente qu’on ne le pensait : 20 Etats sont actuellement touchés aux Etats-Unis (ainsi que deux provinces au Canada). Par ailleurs, la surveillance réalisée entre 1996 et 1999 avec l’aide des chasseurs permet d’estimer un taux d’incidence dans le Colorado et le Wyoming de 5% chez le Cerf mulet, 2% chez le Cerf de Virginie et de <1% chez le Wapiti des montagnes Rocheuses[4].

Les aspects cliniques de la MRC sont souvent discrets, un amaigrissement progressif étant le principal signe clinique. Les autres symptômes pouvant être signalés sont une apathie, une agressivité, une sialorrhée, des grincements de dents et une polyurie, l’évolution de la maladie durant environ quatre mois. Comme dans le cas de la tremblante, on a pu observer que dans les troupeaux atteints, le taux d’incidence de la MDC dans les cohortes augmentait alors qu’inversement, l’âge des animaux au moment de la mort déclinait, montrant ainsi l’adaptation progressive du prion à la génétique de l’hôte, avec une diminution du temps d’incubation de la maladie dans l’élevage atteint.

La forte prévalence de la maladie dans les élevages en captivité ou dans les parcs a justifié de nombreuses études sur la MDC pour comprendre les modes de transmission. Il s’avère que la répartition de l’agent infectieux dans l’organisme des cervidés est comparable à celle observée dans la tremblante du mouton. La présence du prion dans la salive, dans l’urine et dans les fèces des cervidés atteints a permis de suspecter une transmission horizontale par contact direct ou du fait d’une contamination de l’environnement (sol ? plantes ?). Ceci n’est pas sans rappeler «les champs à tremblante» permettant d’expliquer la pérennisation de cette maladie chez le mouton. Une transmission maternelle est également fortement suspectée, ce qui n’est guère étonnant puisque nous avons eu l’occasion, avec l’équipe de notre confrère Claude Couquet à Limoges, de démontrer cette possibilité chez une brebis née d’une mère atteinte de tremblante naturelle il y a plus d’une dizaine d’années.

En Amérique du Nord, l’éradication de la MDC est impossible. Si le risque zoonotique lié à la MDC semble très faible (mais des recommandations sont faites aux chasseurs), l’extension de la maladie chez les cervidés en Amérique du Nord reste inquiétante. Seules des mesures peuvent être préconisées pour diminuer le taux d’incidence de la maladie. Elles reposent sur une diminution de la densité animale chez les cervidés, notamment en éliminant les mâles, plus souvent infectés que les femelles.

En ce qui concerne l’Europe, il importe de comparer la souche du prion norvégien avec les souches américaines de MDC. Enfin, la découverte d’un seul cas malgré la mise en place dans certains pays européens depuis plus de 10 ans d’un système de surveillance, démontre l’aspect sporadique de cette affection au même titre que l’ESB, qu’il s’agisse de la souche classique ou des souches atypiques.

Alain Delacroix

Ancien professeur titulaire de la chaire "Chimie industrielle - Génie des procédés" du Conservatoire national des arts et métiers

Une explosion est le résultat d’une réaction physicochimique dont la vitesse est très élevée et qui génère une importante quantité d’énergie dans un temps très court. La brusque montée de pression correspondante crée une onde de choc dont la vitesse est un indicateur de sa puissance de destruction. Si cette vitesse est inférieure à la vitesse du son, c’est une déflagration, si elle est supérieure, c’est une détonation et dans ce cas, les effets brisants sont très importants. Les explosifs militaires ont une vitesse de détonation qui peut être supérieure à 9000 m/s. Un explosif est alors une molécule ou un ensemble de molécules qui libèrent une grande quantité de gaz en un temps très court.

De très nombreux produits peuvent exploser. On distingue ceux qui sont occasionnels, tel le nitrate d’ammonium, et ceux qui sont intentionnels, les explosifs civils (mines, travaux publics) et militaires. Il existe des dizaines de groupes explosophores dont la présence dans une molécule peut conduire à la rendre explosive, par exemple NO2, -O-O-, etc. Des méthodes existent permettant de prévoir et de calculer la dangerosité d’une molécule.

La poudre noire était connue des Chinois depuis le début de l’ère chrétienne mais c’est au XIVe siècle que commence son utilisation balistique. C’est un mélange de nitrate de potassium KNO3, de soufre et de carbone. En réagissant, ce mélange fournit une grande quantité de gaz selon la réaction :

2 KNO3 + S + C -> K2S + 3CO2 + N2

En dehors du soufre et du charbon trouvés à l’état naturel, le nitrate, appelé salpêtre, était recherché jusqu’au XVIIIe siècle au fond des étables puisqu’il constitue les efflorescences caractéristiques sur les pierres calcaires humides. Le mélange, difficile à réaliser, était obtenu par un broyage très fin dans des moulins situés dans les poudreries. Ceux-ci explosaient souvent et le poudrier devait marcher avec des chaussons de cuir et sans cogner le sol. C’était le célèbre pas du poudrier ! (le pétardier, qui faisait sauter les portes des forteresses au XVIe siècle, avait, lui aussi, une durée de vie fort limitée). En 1794, un stock de 1000 tonnes de poudre a explosé au château de Grenelle faisant des centaines de morts. On en a déduit à l’époque qu’il fallait éloigner les poudreries des villes. La poudrerie de Grenelle est alors transférée à Meudon !

Compte tenu de l’instabilité de la poudre noire, les chimistes ont commencé, dès le XVIIIe siècle, à chercher des produits plus sûrs. Berthollet, avec du sucre et du chlorate de potassium, a inventé les cheddites. En 1846, Bottger et Schonbein fabriquent la nitrocellulose (coton poudre), stabilisée plus tard par Paul Vieille. La même année, Sobrero découvre les propriétés du nitrate de glycérol, d’où la nitroglycérine stabilisée par Alfred Nobel, ce qui a conduit à la dynamite.

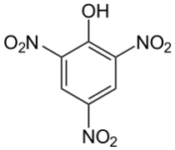

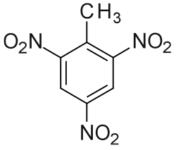

A la fin du XIXe siècle et pendant la guerre de 14-18, compte tenu des quantités énormes impliquées, on a développé une industrie chimique lourde. En France, on a utilisé l’acide picrique et en Allemagne, le trinitrotoluène (TNT). Ces deux produits ont les formules simples suivantes :

Entre les deux guerres, on a découvert l’hexogène et la pentrite, produits qui commencent à avoir des formules sophistiquées et sont difficiles à fabriquer. L’hexogène a une vitesse de détonation de 8700 m/s. Un explosif moderne est maintenant l’association de groupes oxydants tels que NO2 avec un squelette carboné instable associé à une structure solide complexe.

Cependant, de très nombreuses molécules ou mélanges peuvent exploser et sont faciles à produire. Il suffit souvent de mélanger un produit très oxydant : nitrate, perchlorate, eau oxygénée, avec un produit réducteur : soufre, sucre, hydrocarbure, acétone, etc. Un explosif bien connu est un mélange de fioul et de nitrate d’ammonium.

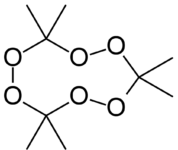

Quant au TATP, de sinistre réputation, c’est un peroxyde, le triacétone triperoxyde, découvert en 1895 par Richard Wolffenstein. Il se prépare à partie d’acétone et d’eau oxygénée en milieu acide. C’est un solide blanc dont la vitesse de détonation est de l’ordre de 5000 m/s. Ses matières premières étant très accessibles et sa préparation étant relativement facile par un chimiste, il est maintenant souvent utilisé par les terroristes. Sa formule développée sous la forme trimère est la suivante :

Il existe donc de très nombreuses molécules ou mélanges de produits susceptibles de conduire à des explosions occasionnelles ou intentionnelles. Même un kilogramme de farine pulvérisé dans l’air et enflammé peut donner une forte déflagration. Des personnes mal intentionnées et pas forcément bonnes chimistes disposent donc malheureusement d’un large éventail de méthodes et produits pour perpétrer leurs forfaits.

Jean Audouze

Astrophysicien, directeur de recherche émérite au CNRS

Le 4 juillet 2012, le CERN de Genève annonçait la mise en évidence expérimentale, grâce à son Large Hadron Collider (LHC), du fameux boson de Higgs, la particule élémentaire qui confère leur masse aux autres, dont l’existence, imaginée en 1954 par Robert Brout (1928-2011), François Englert et Peter Higgs (les deux derniers furent lauréats du prix Nobel de physique 2013), vient donc compléter le tableau «standard» des particules. Pour les physiciens de toutes nationalités travaillant dans ce domaine, cette annonce était considérable et justifiait a posteriori les efforts budgétaires, technologiques et intellectuels ayant permis cette découverte.

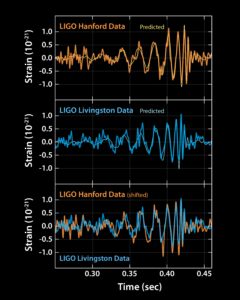

Environ trois ans et demi après, à savoir le 11 février 2016[1], se tint au siège de la National Science Foundation (NSF) à Washington une conférence de presse suivie par le monde entier, annonçant la première mise évidence expérimentale par l’observatoire américain à ondes gravitationnelles LIGO (décrit plus loin) d’une forte émission de telles ondes (fig. 1).

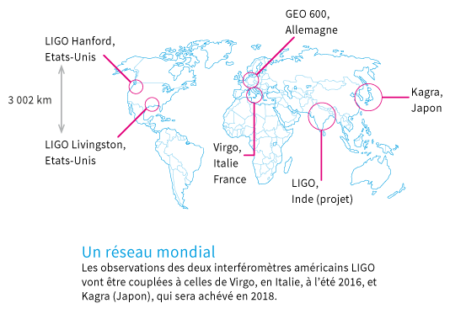

Le phénomène responsable de la production de ces ondes est la coalescence de deux trous noirs stellaires de masses respectives de 29 et 36 masses solaires en un seul objet, également un trou noir de 62 masses solaires – les 3 masses solaires de différence ayant été dissipées sous forme d’énergie véhiculée par les ondes gravitationnelles ainsi détectées. La distance par rapport à nous de ce phénomène grandiose a été évaluée à 1,2 milliards d’années-lumière ; on ne connaît pas précisément la direction dudit phénomène car deux antennes sont insuffisantes pour accomplir la triangulation appropriée. Les astrophysiciens qui procédèrent à ces détections seront en meilleure situation quand l’instrument européen VIRGO, qui est situé à côté de Pise en Italie et qui est de taille comparable (3 km pour VIRGO et 4 km pour les antennes de LIGO), sera lui aussi en opération, ce qui est prévu pour la fin de cette année.

L’émission de telles ondes gravitationnelles correspond à une brusque mais infinitésimale oscillation de l’espace induite par le mouvement de grandes masses telles que celles de trous noirs dits massifs (quelques dizaines de masses solaires) ou supermassifs[2] (quelques millions voire quelques milliards de masses solaires) ou encore celles des étoiles à neutrons encore appelées pulsars. La théorie de la relativité générale d’Einstein établie il y a cent ans, qui relie la géométrie de l’espace-temps à la gravité induite par le contenu matériel de l’Univers prédit de telles émissions.

Mais Einstein croyait que leur caractère particulièrement ténu[3] empêcherait que l’on puisse les détecter un jour ! Pour comprendre la raison du caractère infime de ces ondes, il faut se souvenir que l’intensité relative de l’interaction gravitationnelle par rapport à celle de l’électromagnétisme est dans un rapport 1 / 1 suivi de 35 zéros. L’impression de leur apparente égalité vient du fait que la force électromagnétique s’exerce entre des éléments pouvant porter des charges électriques (ou magnétiques) positives (ou négatives) alors qu’il n’y a pas d’antigravité et donc que cette force gravitationnelle n’est pas «écrantée» comme peut l’être l’électromagnétisme.

Si la détection de cette émission d’ondes gravitationnelles par des instruments dédiés au sol constitue une découverte d’une importance considérable, il convient de rappeler que les astrophysiciens Russel A. Hulse et Joseph H. Taylor (tous les deux récipiendaires du prix Nobel de physique 1993) ayant découvert en 1974 le système binaire de pulsars PSR B1913+16 avaient mesuré alors leur ralentissement et interprété également ce phénomène en termes d’émission de telles ondes.

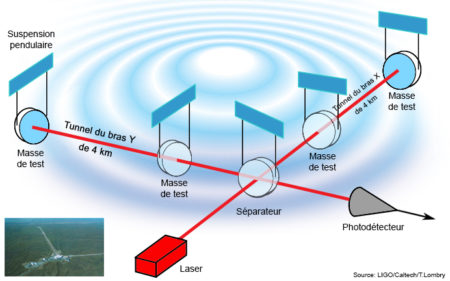

L’annonce de février 2016 concernait un événement dont la détection eut lieu le 14 septembre 2015 grâce aux instruments de LIGO (pour Laser Interferometer Gravitational Wave Observatory), quelques jours après sa remise en service effective ayant eu lieu après une amélioration de sa sensibilité qui s’était étalée sur plusieurs années. Cet observatoire LIGO, d’un genre très particulier, est constitué de deux interféromètres optiques de 4 km de long chacun situés à 3000 km de distance l’un de l’autre : une station est localisée à Hanford dans l’Etat de Washington et l’autre fut construite à Livingstone en Louisiane. Il s’agit dans les deux cas d’interféromètres Michelson, dont le schéma optique est reproduit figure 2.

Le 14 septembre donc, un signal (reproduit figure 1) qui dura 0,3 secondes fut d’abord détecté par l’antenne de Livingstone puis 7 millisecondes après, un signal de forme strictement identique fut repéré par celle de Hanford. La différence entre ce délai de 7 millisecondes et les 10 millisecondes que mettrait un signal lumineux pour aller de Livingstone à Hanford permet de déterminer la distance à laquelle se trouve le phénomène émetteur. Comme les astrophysiciens travaillant à se convaincre que ce signal correspond bien à l’émission d’ondes gravitationnelles étaient «échaudés» par une annonce du même type proclamée un peu à tort à partir d’observations de la polarisation du rayonnement diffus cosmologique (le fameux rayonnement à 2,7 K) effectuées à l’aide du télescope BICEP 2 installé au pôle Sud, ils prirent cinq mois pour ce faire, ce qui fait que la publication de cette détection, signée par 1000 scientifiques (dont 75 Français), apparut en février dans la revue Physical Review Letters.

L’idée d’utiliser des interféromètres optiques et de mesurer des variations minuscules de leur base en observant la perturbation correspondante des franges d’interférence fut proposée dès les années soixante par le physicien Jo Weber, alors professeur à l’université du Maryland. Mais ses dispositifs étaient loin d’avoir la sensibilité requise pour de telles détections. Cet astrophysicien ne cachait pas son amertume quand on avait la chance, comme ce fut mon cas, de converser avec lui. De fait, ayant été l’étudiant de thèse de George Gamow, il reprochait à sa mémoire de ne pas lui avoir suggéré de découvrir le rayonnement radio fossile à 3K, détecté de façon fortuite en 1965 par A. Penzias et R. Wilson. En 1992, Kip Thorne et Ronald Drever du California Institute of Technology (Caltech) et Rainer Weiss du Massachussets Institute of Technology (MIT) convainquirent la National Science Foundation (NSF) de financer la construction de LIGO avec un budget d’environ 620 millions de dollars.

Plus de 23 ans se sont donc écoulés entre la décision de construire ces instruments et l’obtention de ce résultat magnifique ! Les agences de recherche comme la NSF, le CERN ou celles qui opèrent dans l’espace sont donc obligées de parier sur le succès des instruments qu’ils financent et ce, pendant des temps très longs sans aucune commune mesure avec la périodicité des rendez-vous électoraux.

Egalement au début des années quatre-vingt-dix, une équipe constituée principalement d’astrophysiciens français et italiens conçut le programme VIRGO (du nom du superamas de galaxies auquel appartient notre Voie lactée) qui fut, lui, financé par un consortium comprenant le CNRS, le Centre national de la recherche d’Italie, et des contributions plus modestes en provenance de la Hongrie, des Pays-Bas et de la Pologne. Il en résulta un interféromètre situé à côté de la ville de Pise dont les bras mesurent 3 km. Pour que VIRGO atteigne la sensibilité requise pour pouvoir détecter ces émissions, il faut attendre la fin des opérations d’amélioration des détecteurs, prévue à l’été ou à l’automne de cette année. A ce moment-là, le partage des données obtenues par les deux antennes de LIGO et par VIRGO permettra de déterminer la position de l’événement émetteur des ondes gravitationnelles ainsi détectées.

Les porte-parole de LIGO qui se sont exprimés au cours de la conférence de presse de février ont pu dire très justement que les astronomes voient s’ouvrir une ère nouvelle de leur discipline avec ce type de détection, un peu comparable à celle qui débuta en 1609 lorsque Galilée pointa sa lunette astronomique en direction de la Lune : nous avons désormais accès à des phénomènes tout à fait nouveaux comme la fusion de deux trous noirs trop distants pour que la lumière qui les entoure soit perceptible avec nos télescopes. D’ailleurs LIGO et VIRGO n’ont pas vocation à demeurer les seules installations en mesure d’accomplir des observations en astronomie gravitationnelle. La figure 3 montre la distribution géographique de ces différents observatoires d’un genre nouveau.

La fréquence des ondes gravitationnelles susceptibles d’être détectées par ces observatoires au sol se situe dans l’intervalle de 10 à 1000 Hz. Depuis plusieurs années, l’ESA (maintenant seule car la NASA a mis fin à cette collaboration précise en 2011) travaille à la conception d’un projet spatial très ambitieux appelé eLISA qui consistera en un ensemble de trois satellites formant un triangle équilatéral d’un million de kilomètres de côté ayant deux bras chacun et qui évoluera dans un plan faisant un angle de l’ordre de 20° avec celui de l’écliptique ; cet ensemble de trois interféromètres Michelson étant capable de détecter des ondes gravitationnelles dont la fréquence est comprise entre 0,001 et 1 Hz. (fig. 4). Les astrophysiciens prédisent que cet instrument spatial, dont le lancement est prévu en 2034, doit être capable de détecter les ondes gravitationnelles émises par les trous noirs supermassifs se trouvant au centre de la plupart des galaxies spirales proches de la nôtre. Pour qualifier cette mission très ambitieuse, un prototype à une seule antenne intitulée LISA Pathfinder a été lancé le 3 décembre 2015 vers le point de Lagrange L1 (un point situé entre le Soleil et la Terre où les forces de gravité imprimées par ces deux astres s’annulent). Cette mission a pour objectif de tester les instrumentations et les systèmes technologiques qui seront embarqués sur eLISA. Les procédures de présélection de cette mission qui fait partie du programme «lourd» intitulé «Cosmic Vision» de l’ESA doivent débuter cette année.

Entre l’existence théorique du boson de Higgs et sa mise en évidence expérimentale, il a fallu attendre 58 ans. Un siècle s’est écoulé entre la formulation de la théorie de la relativité générale par A. Einstein et cette quasi miraculeuse détection de septembre 2015. Dans les deux cas, les physiciens impliqués dans ces efforts expérimentaux ont dû d’abord convaincre les agences de financement de la recherche de consacrer des budgets conséquents à leurs projets ; ensuite surmonter de nombreux problèmes technologiques ; enfin, consacrer de longs mois à vérifier la validité de leurs détections. Dans les deux cas, «le jeu en vaut la chandelle» car des pans importants de la physique sont ainsi justifiés. De plus, dans le cas des ondes gravitationnelles, un nouveau chapitre de l’histoire de l’astronomie vient de débuter maintenant.

Jeanne Brugère-Picoux

Professeur honoraire de pathologie médicale du bétail et des animaux de basse-cour (Ecole nationale vétérinaire d’Alfort), membre de l’Académie nationale de médecine, ancienne présidente de l’Académie vétérinaire de France

Le 20 mars dernier, le ministère a annoncé un cas d’ESB dans un élevage de 400 vaches Salers dans les Ardennes. Quelques jours plus tard, le laboratoire anglais de référence a confirmé que la souche en cause était la souche anglaise, dite ESB classique (ESB-C).

L’isolement de la souche anglaise dans un cheptel français est une surprise car les deux derniers cas isolés datant de 2013 en France étaient des souches atypiques, comme ceci a été observé dans plusieurs pays depuis la disparition progressive des animaux ESB NAIFs[1] puis des animaux superNAIFs[2] et hyper-NAIFs[3]. D’ailleurs, il n’y avait eu que deux cas d’ESB-C signalés l’année dernière, l’un au Royaume-Uni et l’autre en Irlande.

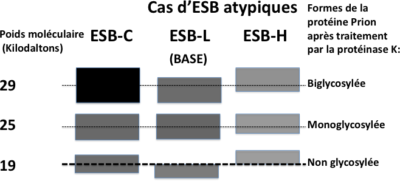

Les deux souches atypiques connues (depuis l’année 2004) se différencient principalement de la souche ESB-C par le poids moléculaire de la forme non glycosylée de la protéine prion résistante à la protéinase K (PrPres) (cf. fig. 1). Ce poids est plus faible pour la souche ESB-L (pour Low) et plus élevé pour l’ESB-H (pour High). Au 2 avril 2016, 122 cas d’ESB atypiques (38 ESB-H et 84 ESB-L) ont été détectés en Europe (EFSA, 2014, OIE, 2016)[4] dont 33 en France (17 ESB-L et 16 ESB-H).

En comparant le poids moléculaire de la forme non glycosylée de la protéine prion résistante à la protéinase K de la souche ESB-C, on observe le poids plus faible de la souche ESB-L ou plus élevé de la souche ESB-H. La plus ou moins faible résistance à la protéinase K, représentée dans ce schéma par des intensités différentes pour les glycoformes de chaque souche ESB, est également un critère de diagnostic des souches ESB-L et ESB-H.

Ces cas sporadiques permettent de penser que l’ESB existait avant l’apparition de l’anazootie anglaise, où l’origine alimentaire ne fait aucun doute. Nous avons toujours pensé que la souche à l’origine de cette catastrophe ne provenait pas de carcasses de moutons atteints de tremblante à l’origine mais plutôt d’une souche bovine amplifiée par le recyclage des carcasses de bovins britanniques infectés dans les farines de viandes et d’os. L’observation de l’émergence d’une souche ESB-C après plusieurs passages sur souris d’une souche atypique ESB-H permet même d’émettre l’hypothèse qu’il puisse y avoir plusieurs souches d’ESB, celles-ci pouvant être parfois même associées chez un même bovin, comme cela est connu dans la tremblante du mouton.

L’ESB était certainement une maladie rare non reconnue avant 1985. Il y avait eu cependant de très rares descriptions de la maladie bovine, dont une datant de 1883 en Haute-Garonne par notre confrère M. Sarradet[5]. Nous connaissions aussi l’existence d’un cas dans l’Allier observé dans les années soixante chez une vache charolaise par le Médecin Général Court, spécialiste de la maladie de Creutzfeldt-Jakob[6], ce cas ayant été confirmé à l’examen histologique. Il était donc logique de penser que l’ESB existait depuis longtemps sous une forme sporadique.

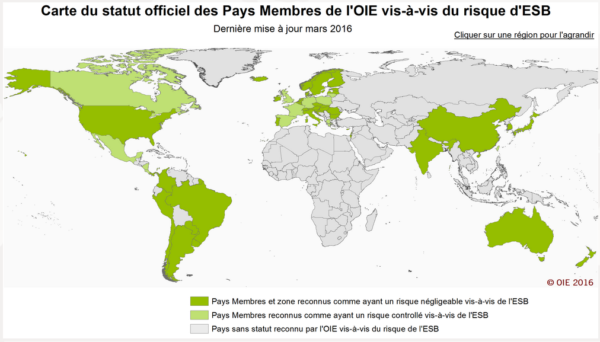

La France venait d’obtenir le statut de « pays à risque négligeable vis-à-vis de l’ESB ».

C’est le premier cas d’ESB-C détecté en France depuis 2011. Ce dernier cas français avait été découvert chez une vache née en 2004. Un délai de 11 ans entre l’année de naissance de cette vache et l’année du test de ce cas était dépassé, le statut de notre pays avait été reconnu « à risque négligeable » en 2014 par le code terrestre de l’organisation mondiale de la santé animale (OIE ou office international des épizooties). Nous avons perdu ce statut avec le cas de mars 2016, en retrouvant celui de « risque maîtrisé », modifiant ainsi la liste des tissus considérés comme MRS pour les bovins nés et/ou élevés en France, abattus dans les abattoirs français (à nouveau, doivent être considérés comme MRS : la colonne vertébrale des bovins âgés de plus de 30 mois, les amygdales, les quatre derniers mètres de l’intestin grêle, le cæcum et le mésentère)[7]. Cela veut aussi dire que nous ne retrouverons notre statut de risque négligeable que dans 6 ans, la vache déclarée en mars dernier étant âgée de 5 ans.

A juste titre, le ministère avait pourtant allégé récemment le programme de surveillance de l’ESB en relevant l’âge des animaux testés à l’abattoir aux sujets nés avant le 1er janvier 2002[8] puis à l’équarrissage (48 mois en 2013).

Par ailleurs, en application de la réglementation liée aux souches ESB-C, la cohorte des bovins nés 12 mois avant ou après la vache atteinte d’ESB (soit près d’une centaine de bovins sur un cheptel de 400) seront euthanasiés pour vérifier « l’origine alimentaire » du cas d’ESB. Il en sera de même pour les veaux nés de cette vache contaminée (alors qu’il n’a jamais été démontré la possibilité d’une transmission maternelle de l’ESB, cette possibilité étant connue dans la tremblante du mouton). Cette recherche sur les cohortes était justifiée lors d’une suspicion de contamination alimentaire mais elle ne l’est plus maintenant car il est fort probable que ce cas d’ESB-C corresponde une forme sporadique au même titre que les souches atypiques.

Il faut espérer que les pays qui commençaient à ouvrir à nouveau leur marché pour l’exportation de bovins français, comme Singapour, le Vietnam, l’Afrique du Sud, le Canada ou l’Arabie Saoudite, ne changeront pas d’avis après la modification de notre statut.

L’annonce du cas d’ESB-C dans les Ardennes a alerté les médias. Certains ont même annoncé le retour de l’ESB alors que ce cas isolé ne fait que démonter l’efficacité de notre système de surveillance de l’ESB et la transparence de nos déclarations. Il importe de savoir que l’ESB est devenue à nouveau une maladie rare, soit moins d’un cas par million de bovins adultes testés, ce taux d’incidence étant identique à celui de la maladie de Creutzfeldt-Jakob sporadique qui ne reconnaît pas une origine alimentaire. Il faudrait revoir la réglementation concernant l’ESB en tenant compte de cette disparition d’un risque de contamination alimentaire.

Enfin, la découverte sur le terrain ou par passage sur la souris de différents prions bovins montre que l’ESB, quelle que soit sa souche, restera une maladie rare dans le monde entier et que cela justifie de maintenir l’interdiction des MRS chez les bovins âgés selon le statut de « risque négligeable » afin de rassurer le consommateur.